【开普云AI实践】风格迁移:如何泛化一种画风进行内容创作?

(来源:开普云)

引言

作为生成式人工智能的一个重要研究方向。个性化风格迁移是根据给定的一张或多张图像生成具有相同风格的图像。将带有某种风格的图像输入到生成模型,模型学习输入图像中带有的图像画风,从而创作出多样、高质量且富有创意的个性化作品。常见的图像风格如水墨画、剪纸画、日漫、赛博朋克、3D动画、像素艺术、吉卜力等,虽然大多数生图模型的基础模型就可以支持一些图像风格的生成,但这些风格一般偏大众,相对普通。个性化风格迁移能够捕获任何领域的风格,它可以是一个小众、细分的独特风格,比如某外漫画作家的独特画风。这样的需求同样旺盛,尤其是在艺术创作、社交娱乐、文化传媒等领域,更注重图像风格独创性的领域。个性化生成任务的一个关键在于保真度和泛化性,期望生成图像与输入图像的风格有极高相似度,同时可以灵活地组合、迁移到不同的场景。此外,推理速度也至关重要,更快速地生成有利于提升用户体验。鉴于上述挑战,目前大多数解决方案都存在不同的缺陷。

开普云提出了低秩自适应个性化风格迁移方法,将LoRA 方式的优异性能与适配器策略的零样本能力相结合。该方法构建了一种低维线性LoRA网络,并冻结其中部分参数。在确保模型学习到风格的同时,提升这部分网络的训练效率。测试来看,这种方法既具有高保真度又具有零样本能力,并且推理高效。

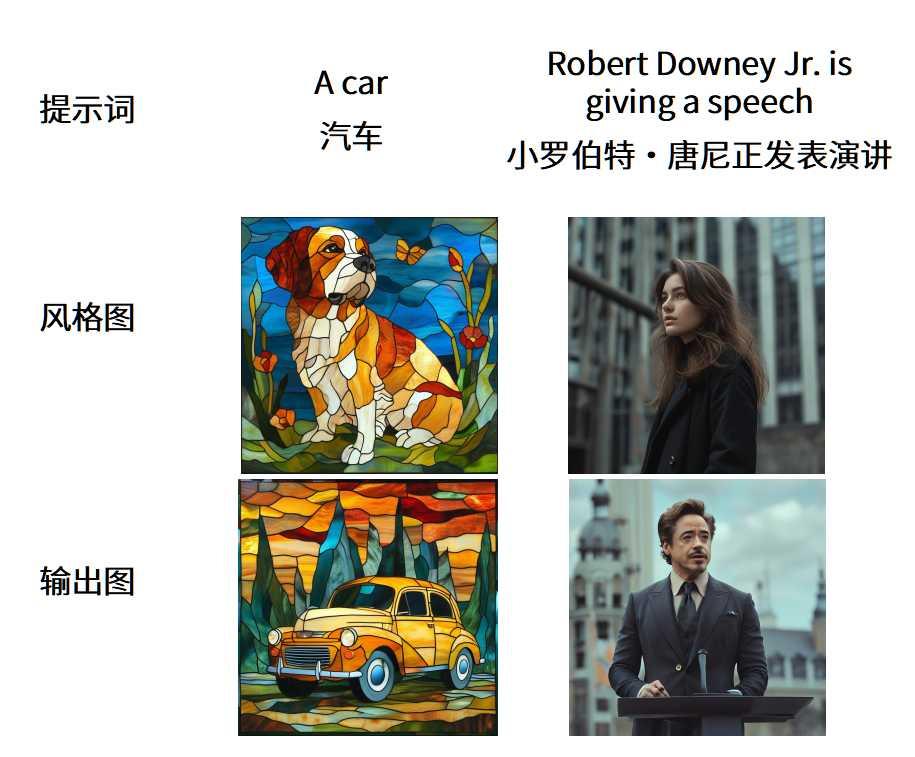

推理测试时,输入提示词和一张风格图,就会输出带有该风格,且符合提示词描述的画面。例如:

现有的个性化图像生成方法

最新的个性化图像生成方法通常可以分为基于微调的方法和无需微调的方法。基于微调的方法,如LoRA和 DreamBooth,会根据用户提供的特定数据更新模型参数,能够准确理解并保留输入的特征信息。理论上,这些方法主要针对少批量样本情况设计,为不同的风格定制不同的模型。因此,高计算成本、训练不稳定以及训练过程漫长等问题使得这类方法不太便捷。

无需调优的方法,最典型的IP-Adapter ,通常利用额外的插件结构来编码图像风格的信息。通过图像风格相关的特征输入到冻结的基础模型中,这些方法会对推理过程产生影响,最终生成定制化风格的结果。这种额外的适配器结构会提前使用大型数据集进行训练,并在推理时冻结。这些方法摆脱了在线训练,便于实际应用。然而,对于这些方法而言,编码的输入信息与基础模型之间的交互依赖于一组固定的额外交叉注意力模块,这可能会降低生成图像的质量,导致生成图像不自然且缺乏真实感,并且无法恢复精细的细节。先前的方法很难同时在保真度、泛化性两者间取得平衡。

低秩自适应生成方法

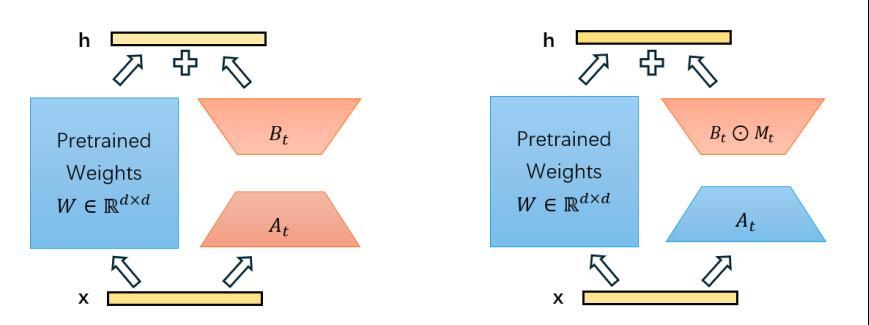

开普云提出了一种低秩自适应生成方法,它实现了极高的风格保真度、快速推理速度和更强的泛化性。它使用自适应插件网络对输入图像进行编码,这遵循了诸如IPAdapter等无需调优方法的设计。然而,与这些方法利用编码后的标记进行注意力计算不同,我们直接通过插件网络生成LoRA权重。这种策略不仅保持了适配器策略的零样本能力,还继承了LoRA策略通过调整全局参数而无需实际微调过程的表示能力和高质量生成效果。

考虑到LoRA中参数数量庞大,为降低训练难度,我们首先将LoRA参数投影到线性LoRA空间, 而非直接在原始参数空间中进行训练。这样生成的LoRA权重可以表示为可训练的线性组合。我们使用感知器重采样器(如IP-Adapter中所用)将输入图像转换为向量。为了编码输入图像,我们使用CLIP提取图像特征。上述特征提取器在整个训练过程中被冻结。

LoRA空间

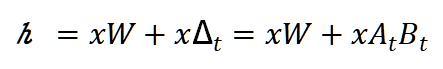

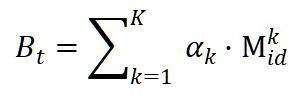

当前业界使用的扩散模型结合LoRA用于生成图像的工程中,LoRA的每一层包含下采样矩阵At、上采样矩阵Bt、各自包含查询、键、值和输出矩阵。使用随机高斯分不分初始化矩阵At,用零初始化矩阵Bt,以保证在训练开始时Δt=0,计算公式如下:

本文中采用LoRI中冻结At,仅训练Bt的方式,提升训练效率,这种方法已被证明可以在大幅减少可训练参数的同时,性能下降极小。即将At固定为随机矩阵,仅通过Bt学习如何组合固定的子空间。也就是冻结At,无需其对应的存储梯度和优化器状态,大幅减少了内存消耗。在推理过程中,与一般LoRA 类似,LoRI通过将AtBt加到W上合并,与全量微调相比没有额外的推理延迟。

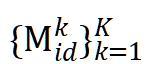

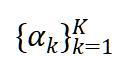

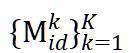

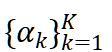

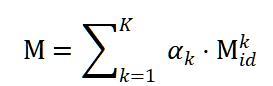

在衔接图像特征时,将Bt的每个矩阵投影到一个较小的K 维向量M。LoRA层的数量N,其投影维度为N×8K,即

自适应结构

自适应结构包括:图像编码器、感知重采样器,最后结合LoRA。

图像编码器

与IP-Adapter相似,图像编码器使用一个预训练的CLIP图像编码器,由“图像-文本”组成的大数据集通过对比学习训练而来,在训练阶段,CLIP图像编码器是冻结状态。图像经过CLIP图像编码器后成为表示图像的特征向量,随后将该向量投影到低维,投影网络由一个线性层和一个归一化层组成。

感知重采样器

感知重采样器内部是Transformer网络,图像特征被注意力机制进一步提取。感知重采样器有4层,每层两个注意力模块。感知重采样器的输出,即组合系数 ,后面用于计算输出的LoRA权重。

LoRA组合

实验

在模型预训练时,使用StyleGallery作为数据集,该数据集由三部分开源数据集整合而来。包括JourneyDB Sun等人在MidJourney使用的风格数据集;具有大量细粒度高品质绘画风格的WIKIART Phillips & Mackintosh数据集,如点彩和水彩画;来自LAION-Aesthetics的风格化图像子集。相比于直接使用Laion-Aesthetics,StyleGallery数据集中图像的风格分布更加平衡和多样化。

不同于一般“描述词-图像”的文图数据对,我们使用“描述词-风格-风格化图像”组合作为训练数据对,额外输入一张“风格”图。其中,描述词使用BLIP-2生成,而非直接使用StyleGallery数据集自带的描述词,这是因为该数据集自带的描述词中大多包含对该图风格的描述。而本文方法的风格特征来自“风格”图,需要避免描述词引入风格相关的描述引起混乱。

结语

开普云提出的低秩自适应个性化风格迁移方法,具备独特的自适应结构、创新的 LoRA 空间运用以及精心设计的实验方案,在个性化图像生成领域展现出了良好性能,克服了现有方法在保真度、泛化性和推理速度等难题,为艺术创作、社交娱乐、文化传媒等对图像风格独创性要求极高的领域带来了新的可能。